2.2 Le Champ de Vision de la Voiture Autonome

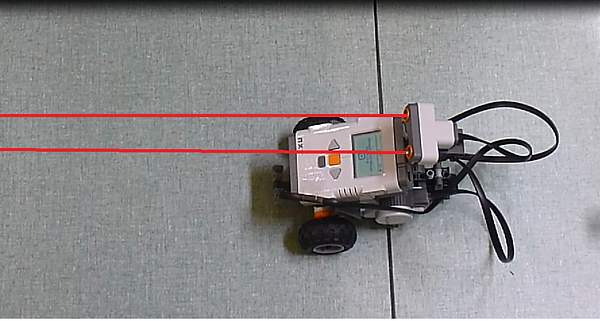

Comme nous ne disposons pas de voiture autonome pour vérifier son champ de vision, nous avons pensé à mesurer celui du robot qui nous était mis à disposition. En effet, celui-ci symbolisait précédemment une voiture dotée d’intelligence artificielle.

Nous avons donc cherché à établir l’étendue de son champ visuel grâce à l’expérience suivante.

Expérience de détermination du champ de vision du robot LEGO programmable :

Tout d’abord, nous savons que le robot doté de capteurs utrasoniques, « voit » les obstacles grâce à deux de ces capteurs qui émettent et réceptionnent des ondes sonores. Nous savons cependant que les ondes sonores se propagent en ligne droite.

Hypothèse

Le champ de vision du robot se résume à deux lignes droites qui se situent juste devant lui : un objet qui serait donc sur l’intersection des ondes sonores émises par l’un des deux (ou les deux) capteurs serait donc perçu par le robot.

Matériel expérimental :

- le robot LEGO programmable MINDSTORM muni d’un programme de détection d’obstacles (détection faite grâce aux deux capteurs sonores)

- un objet de largeur inférieur à la distance se situant entre les deux capteurs sonores (ici un marqueur Velleda)

Dispositif

On démarre le programmable de détection d’obstacles du robot : le robot roule lentement et s’arrêtera s’il détecte un objet se situant à moins de 40 cm de ses capteurs.

Avec précautions, pendant que le robot avance, on approche entre ses deux capteurs sonores le marqueur.

On positionne ainsi le marqueur devant le premier capteur, on note la réaction du robot. Ensuite on positionne le marqueur entre les deux capteurs sonores, on note aussi la réaction du robot. Enfin on positionne le marqueur juste devant le deuxième capteur sonore du robot, et on note une dernière fois la réaction du robot.

On déplace aussi le marqueur derrière les capteurs et sur les côtés du robot pour toujours voir si celui-ci le détecte.

Observations

Voici la vidéo de notre expérience

Le robot détecte un obstacle lorsque le marqueur se situe juste devant l’un de ses capteurs, et ne détecte pas d’obstacle lorsque que le marqueur se situe entre ses deux capteurs.

Il ne détecte pas non plus si le marqueur est derrière les capteurs ou sur les côtés.

Interprétations

Comme le robot détecte seulement un obstacle lorsque qu’on place le marqueur juste devant l’un de ses capteurs ou les deux et que l’on sait que des ondes sonores se déplacent toujours en ligne droite, on peut déterminer le champ visuel du robot ici.

L’étendue du champ visuel du robot doté des deux capteurs sonores se résume donc à deux lignes droites devant lui.

L’objet que pourra détecter le robot devra donc être :

-de même hauteur ou plus haut que les capteurs du robot (27 cm)

-de largeur plus importante que la distance entre les deux capteurs sonores (3cm)

Si un obstacle est moins haut ou moins large que les dimensions citées, il ne sera pas perçu par le robot.

Conclusion

Nous avons donc déterminé l’étendue du champ visuel du robot LEGO MINSTORM programmable. Il se résume donc à deux lignes droites parallèles au sol, de hauteur 27 cm et de largeur 3 cm.

Ce champ visuel n’est pas du tout représentatif de celui de la voiture autonome qui grâce à la caméra rotor LIDAR infrarouge est de 360°.

Cependant, nous allons voir qu’il existe une analogie avec les capteurs de notre robot ainsi qu’avec des capteurs de mesure de vitesse situés à l’avant et à l’arrière de la Google car.

Comme nous l’avons dit précédemment, la vision est extrêmement importante pour conduire car elle permet en permanence de capter la quasi-totalité des informations de l’environnement qui nous entoure.

Pour que la voiture autonome soit plus sûre qu’une voiture conduite par un conducteur humain, il faut qu’elle prouve sa supériorité notamment en termes de champ visuel.

Etudions donc l’étendue du champ de vision des actuels prototypes de voitures autonomes.

Tout d’abord, différentes marques automobiles ont tenté de construire des voitures autonomes.

Or, chaque entreprise a créé pour son prototype de voiture autonome, son propre système de « vision ».

En effet, les marques automobiles étant en grande concurrence vu l’ampleur du marché, ne révèlent donc pas les détails techniques de leurs avancées et découvertes technologiques aux autres en ne les diffusant pas sur internet par exemple ou dans des revues scientifiques.

C’est pourquoi nous n’avons que peu d’informations précises sur le fonctionnement des systèmes de vision des voitures autonomes actuelles.

Cependant, nous savons que globalement la « vision » de l’environnement d’une voiture intelligente se base sur les informations apportées par des capteurs, des caméras et des radars répartis sur la voiture. Ces informations sont ensuite toutes traitées en même temps et combinées dans un puissant ordinateur de bord avec des logiciels très perfectionnés. Le logiciel analyse donc toutes les données apportées par les caméras, capteurs et radars situés sur la voiture. Ensuite, le logiciel capable de s’adapter à toutes les situations dans lesquelles la voiture peut se trouver, va prendre des décisions et envoyer des ordres aux roues, freins, moteurs, airbags, ceintures etc. afin de faire face à la situation présente.

Voici donc le fonctionnement général pour s’orienter, d’une voiture autonome.

Intéressons-nous maintenant plus précisément à la Google car.

Tout d’abord, nous avons eu la chance d'entrer en contact avec Guillaume Rolland ancien élève du Loquidy, inventeur du Sensor wake qui a pu pendant qu'il présentait son projet aux Etats-Unis à la Sillicon Valley chez Google, tester la voiture autonome : "Google car". Il a pu poser différentes questions aux américains sur son mode de fonctionnement et nous en a fait ensuite part dans un mail complet.

Photographie de la Google car

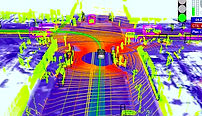

On peut remarquer sur le toit de la voiture, une caméra rotor (qui tourne sur elle-même très rapidement) qui filme de manière permanente l’environnement. Cette caméra fonctionne par émission-réception de laser en infrarouge à 360°, repère ainsi les différents objets environnant ce qui permet ensuite au logiciel de reconstituer l’environnement dans lequel évolue la voiture en 3 dimensions.

Caméra LIDAR infrarouge de même type que celle située sur le toit de la Google car

Images brutes de la vision de la Google car

La Google car possède aussi à l’avant et à l’arrière des radars utrasoniques (comme ceux présents sur notre robot d’expérience LEGO MINDSTORM) fonctionnant eux-aussi en émission-réception et qui permettent de calculer la vitesse des différents véhicules à l’avant et à l’arrière de la Google car.

Enfin, la Google car possède à l’emplacement du rétroviseur intérieur, une caméra qui lit les panneaux de signalisation et détecte aussi les objets mobiles pour pouvoir ensuite anticiper leur trajectoire.

Toutes ces informations apportées arrivent presque instantanément dans l’ordinateur et sont ensuite analysées par un puissant logiciel à bord de la voiture. En fonction des situations, la voiture autonome transmet les ordres nécessaires : s'arrêter car un obstacle se trouve devant elle, éviter une voiture stationnée, tourner car la route comporte des virages, s'arrêter pour laisser passer un piéton sur un passage clouté et des milliers d'autres situations qu'une voiture ordinaire peut rencontrer.

La Google car a donc une étendue du champ de vision de 360° grâce à la caméra rotor sur le toit et complète les informations apportées par cette dernière avec les radars ultrasoniques qui calcule précisément la vitesse des véhicules environnant ainsi que la caméra située sur le pare-brise avant qui lit les panneaux et filme les objets en mouvement devant la voiture.

A cette vision 360° s'ajoute des données GPS. En effet, la voiture réagit avec son environnement proche grâce à son champ de vision 360° mais elle est guidée également par des données GPS et à la Google Street View qui permet à la voiture autonome de comparer sa situation avec les images.

En effet, elle prévoit le trajet grâce au GPS, elle sait à quel moment tourner. Ces données sont combinées à la vision dite "courte" de la voiture intelligente (vision avec radars et caméra). La voiture s’oriente donc grâce aux données GPS (elle sait précisément la présence de bâtiments, de virages, etc.) et analyse son environnement (présence de voitures, piétons, cyclistes etc.) pour faire face aux situations imminentes.

La synchronisation du guidage par GPS avec la vision global de l’environnement permet à la voiture de s’orienter et d’évoluer en toute sécurité sur la route.

Ainsi, grâce aux différentes informations apportées par les capteurs et caméras que possède la Google car combinés données GPS apportés par satellite, la voiture autonome de Google possède un champ de vision de 360°. Il n’y a donc plus de problèmes d’angles morts comme ceux constatés chez le conducteur humain. De plus, nous avons vu que l’humain ne se concentrait que sur son champ de vision central, le reste de son champ visuel n’est pas perçu comme net.

Or, les images et informations collectées par la Google car sont nettes et précises à 360° et le logiciel qui donne son intelligence à la voiture (il permet de s’adapter à une situation donnée) analyse et se concentre sur la totalité de l’environnement.

On remarque donc que la vision de la voiture autonome est beaucoup plus performante sur la route que celle du conducteur humain qui peut être en plus sous l’emprise d’alcool, de drogues, qui peut présenter des maladies oculaires et qui peut être âgé.

Les capacités visuelles de la voiture autonome dépassent donc celle du conducteur humain.